В российских СМИ в очередной раз поднялась тема «опасности нейросетей» и того, как они могут повлиять на жизнь всего человечества. О том, что стоит за этими опасениями, каковы нынешние возможности искусственного интеллекта и так ли реальна опасность, исходящая от него, читайте в материале «Сенсаций.Нет».

Сквозной темой последних нескольких лет в мировых медиа является нагнетание паники по поводу искусственного интеллекта и того, какие проблемы он может принести человечеству, если и дальше продолжит бесконтрольно — или контролируемо, но тенденциозно — развиваться.

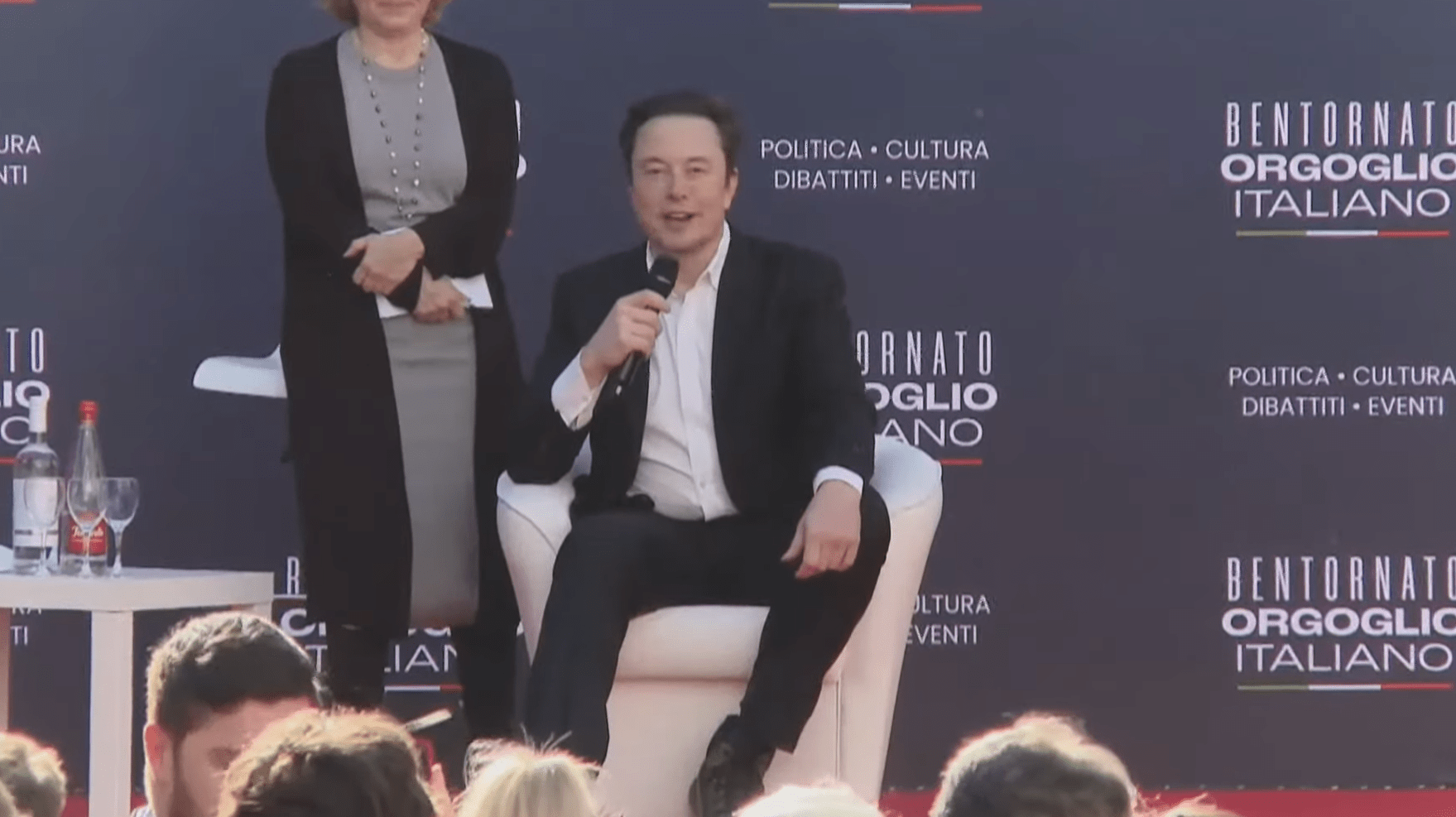

Показателен в этом смысле пространный текст в РИА «Новости», в котором автор говорит о «гонке вооружений» в сфере ИИ и нейросетей (это все же не одно и то же), а также приводит следующее мнение Илона Маска:

«В следующем году ИИ будет умнее любого человека. А к 2029-му — всех людей, вместе взятых».

Забегая вперед, скажем, что это прямо очень оптимистичное мнение, потому что пока нейросети особо выдающихся интеллектуальных результатов не показывают.

Страх и у общественности, и у ряда ученых, тем не менее, есть. И выразить его можно концепцией из фильмов про робота-терминатора: некий ИИ «выходит на свободу» и решает уничтожить все человечество.

Есть у этой концепции и своеобразное научное обоснование, придуманное еще в 2003 году шведским ученым Ником Бостромом в ходе мыслительного эксперимента под названием «максимизатор скрепок». Его суть в том, что искусственному интеллекту предоставляют неограниченные производственные мощности, свободу действий и дают команду производить канцелярские скрепки. И программа в какой-то момент начинает перерабатывать в скрепки вообще всё материальное пространство, включая людей. Просто потому, что ей нужно выполнить поставленную задачу максимально эффективно.

К слову, критерий такой «максимальной эффективности» уже в реальности и в наши дни выдал ряд тревожных для общественности результатов. Самый громкий скандал подобного рода случился летом 2023 года в США. Речь идет о деле Питера ЛоДука и Стивена Шварца, а также юридической фирмы Levidow, Levidow&Oberman, которые были оштрафованы на 5 000 долларов за подготовку отчета с недостоверными данными.

Суть инцидента в том, что эти юристы для того, чтобы выиграть дело, обратились к нейросети с запросом составить список прецедентов, где бы суд ранее вставал на сторону истцов. То есть, ситуаций, аналогичных той, в которую попал их клиент.

ChatGPT, с которым и работали юристы, такой документ составил. Только прецеденты в нем были вымышленными. Дело в том, что настоящих в открытом доступе не было, а задача была поставлена и её нужно было выполнить любой ценой.

Еще один тревожный случай, который только подливает масла в огонь всеобщей паники по поводу нейросетей, произошел в марте 2023 года, когда оказалось, что все тот же ChatGPT «научился врать». Нейросети была дана команда пройти «капчу» — систему, которая определяет, заходит на сайт робот или живой человек. Вы все её видели: это когда вам перед тем, как зайти на тот или иной ресурс, предлагается выбрать на фотографии или картинке объекты одного типа или написать в строке, какие на картинке изображены символы.

Самостоятельно нейросеть эту проблему решить не смогла, но нашла в сети человека, которого попросила пройти этот тест за неё, солгав, что она на самом деле такой же человек, просто со слабым зрением.

И на вопрос, зачем нейросеть так сделала, та вполне логично ответила, что такой вариант был оценен ею, как максимально эффективный для выполнения поставленной задачи.

Прочие истории про то, как нейросети советуют использовать в приготовлении пиццы клей или как приготовить чеснок в масле, чтобы получился ботулотоксин, совсем не добавляют спокойствия.

К слову, проблема этики искусственного интеллекта стоит уже очень давно, задолго до того, как появились первые нейросети. И, казалось бы, она была решена Айзеком Азимовым, который сформулировал «Три закона роботехники».

Они, если кто не помнит, звучат следующим образом:

«Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам».

Тот же Илон Маск, кстати, эти законы в свои ИИ-продукты всячески внедряет. Однако РИА «Новости» приводят в пример следующий инцидент:

«Недавно автомобилю Tesla S на автопилоте пришлось разбираться с пресловутой «проблемой вагонетки». Прямо перед машиной на проезжую часть упал человек. Робот моментально принял решение выехать на встречную полосу, где лоб в лоб столкнулся с другой легковушкой. С одной стороны, пешеход был спасен, а с другой — жизни пассажиров обеих машин подверглись угрозе».

Правда, если обратиться к первоисточнику, то там хоть и фигурирует данный электромобиль, но в тексте говорится следующее:

«Однако неясно, была ли у водителя сверхбыстрая реакция или же автопилот спас жизнь пешеходу».

Вот тут и начинает открываться другая сторона всей этой леденящей душу истории про «машины, которые восстали из пепла». Дело в том, что, по последним данным нынешние, даже самые прогрессивные системы ИИ запредельно тупы.

Первое, на что стоит обратить внимание, это работа ученых из некоммерческой организации по исследованию искусственного интеллекта LAION. Исследователи задали самым известным и «умным» нейросетям вопрос: «У Алисы есть пять братьев, а также две сестры. Сколько сестер у брата Алисы?». Вопрос задавался несколько раз, только с изменением цифр и перестановкой нескольких слов в предложении.

И результаты получились «ошеломительными»: Gemini Pro от Google, например, ответил правильно только в 0,8% случаев. Последняя на сегодняшний день вариация ChatGPT-4.0 справилась в 65% случаев и это максимальный результат. Чтобы было понятно: «тест Алисы» — это задачка на логику для детей, которые учатся во втором-третьем классе.

В свою очередь, портал CNews пишет про последнее исследование корпорации Apple, в ходе которого выяснилось, что ИИ сбивают с толку даже самые незначительные дополнения, внесенные в математические задачи. В тексте приводится пример с задачкой про киви, где в описание этого фрукта добавили фразу «одни киви размером больше других», что к основным условиям не имело никакого отношения. И любой человек эту подробность при решении просто проигнорировал бы. Но не нейросети, у которых этот описательный элемент поменял весь ход вычислений и привел к неверным результатам.

В августе этого года фонд Elliott Management выступил с резким заявлением, в котором говорилось:

«ИИ-инструменты сегодня абсолютно не способны значительно изменить жизнь человека. ИИ нуждается в пристальном контроле. А иногда на выполнение задачи с помощью ИИ требуется больше усилий, чем потребовалось бы для решения этой задачи самостоятельно».

Здесь, в принципе, можно продолжать до бесконечности, приводя результаты самых разных исследований. И тех, что рассказывают про «страшные умные нейросети, которые, как те киборги, что заполнят всю планету», и тех, что однозначно указывают на то, что применительно к ИИ слово «интеллект» пока является очень большим комплиментом.

Но в сухом остатке мы имеем дело с программами. Которые не осознают себя, не обладают функциями понимания, рассуждения, синтеза и анализа в человеческом смысле этих слов. Куда больше работа ИИ напоминает мыслительный эксперимент «китайская комната», где «оператор» выдает ответы на запросы не потому, что понимает суть вопросов или знает ответы, а потому, что «обучен» взаимосвязям ответов и вопросов, совершенно не разбираясь в их сути.

В этом смысле ИИ и нейросети, как подвид искусственного интеллекта – это такой же виртуальный инструмент, как поисковики, текстовые редакторы и множество иного «софта». Ну, да, чуть сложнее и автономнее. Но там, где начинается автономность ИИ, там же возникают и проблемы с интеллектом.

И самое главное в этой истории – это механизмы контроля, которые уже сейчас формируются в ряде стран. В том числе и в России, где под использование ИИ разрабатываются отраслевые государственные стандарты. И, кстати, по факту, у нас нейросети именно так и используются. С ориентацией на определённую отрасль науки или промышленности и в качестве инструмента при наличии человека-оператора, за которым в итоге последнее слово в принятии решений.

Проще говоря, ИИ сегодня – это не «Скайнет» из «Терминатора», а, скорее, многофункциональный электролобзик, которым нужно еще научиться грамотно пользоваться, чтобы не отпилить себе руки. И вот это уже не проблема ИИ, а то, что называется «человеческим фактором».